- 8.8/10 (12 Reviews)

- 4 bulan lalu

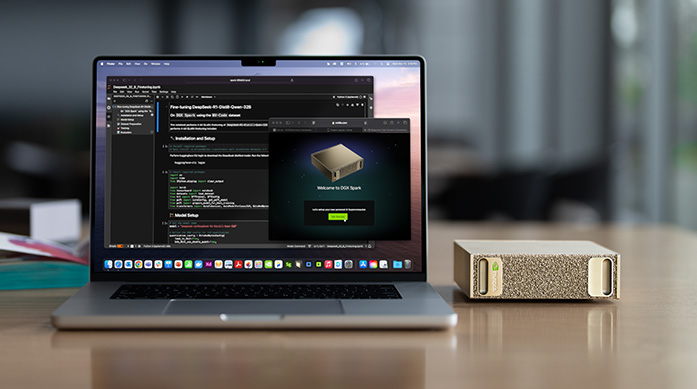

NVIDIA meluncurkan Spark, superkomputer AI personal yang membawa kemampuan AI tingkat data center ke rumah. Simak fitur dan spesifikasinya.

Tahukah Anda bahwa satu rak server GPU Blackwell dari Nvidia dijual seharga hampir $3 juta? Angka fantastis ini mencerminkan betapa besarnya permintaan terhadap chip AI di seluruh dunia. Nvidia kini bukan sekadar raksasa gaming—perusahaan ini telah menjadi jantung dari revolusi AI generatif.

Dengan pengiriman 6 juta GPU Blackwell sepanjang tahun lalu, Nvidia mencatat pencapaian luar biasa. Setiap rak menghubungkan 72 GPU yang bekerja sebagai satu kesatuan raksasa, mampu menjalankan beban kerja AI paling canggih. Namun di balik dominasi GPU, ada kategori chip AI lain yang mulai mencuri perhatian: ASIC kustom.

ASIC atau Application Specific Integrated Circuit kini dirancang oleh hampir semua perusahaan teknologi besar—Google, Amazon, Meta, Microsoft, hingga OpenAI. Chip-chip ini lebih kecil, lebih murah, lebih mudah diakses, dan yang paling penting, dibangun khusus untuk satu tujuan spesifik. Menariknya, pasar ASIC diprediksi tumbuh lebih cepat dibanding pasar GPU dalam beberapa tahun ke depan.

Lanskap chip AI sebenarnya jauh lebih luas. Selain GPU dan ASIC, ada FPGA (field programmable gate arrays) serta berbagai chip untuk edge AI yang beroperasi langsung di perangkat, bukan di cloud. Persaingan semakin ketat, pemainnya semakin banyak. Saatnya kita bedah satu per satu.

Pada Oktober lalu, Nvidia sempat menjadi perusahaan pertama yang menembus valuasi $5 triliun. Pencapaian ini berawal dari mesin gaming mereka—GPU—yang kini mendominasi dunia chip AI. Apa yang membuat GPU begitu istimewa untuk AI?

GPU pada dasarnya dirancang untuk pemrograman paralel. Saat merender gambar atau adegan visual, chip ini harus menghitung semua piksel secara bersamaan. Kemampuan inilah yang sangat cocok untuk kebutuhan AI. Untuk memahami bagaimana GPU menjadi identik dengan AI, kita perlu mundur ke tahun 2012—momen big bang AI yang dikenal sebagai AlexNet.

AlexNet adalah jaringan neural yang sangat akurat, menghancurkan kompetisi dalam kontes pengenalan gambar bergengsi. Ternyata, pemrosesan paralel yang digunakan GPU Nvidia untuk rendering grafis juga sangat efektif untuk melatih jaringan neural. Dalam neural network, komputer belajar dari data, bukan dari kode yang ditulis programmer.

Para peneliti kemudian meretas GPU agar bisa mengekspos kemampuan komputasi paralelnya untuk deep learning. Meskipun beban kerja AI biasanya dipercepat oleh GPU atau ASIC kustom, seringkali masih diperlukan CPU host seperti Grace dalam sistem rak server Grace Blackwell milik Nvidia.

Perbedaan mendasar antara CPU dan GPU cukup jelas. CPU memiliki sejumlah kecil core yang powerful, menjalankan tugas sekuensial untuk keperluan umum. Sebaliknya, GPU memiliki ribuan core yang lebih kecil, fokus pada operasi matematika paralel seperti perkalian matriks yang digunakan untuk memproses struktur data multi-dimensi bernama tensor.

Kemampuan menjalankan banyak operasi secara bersamaan membuat GPU ideal untuk dua fase utama komputasi AI: training dan inference. Training mengajarkan model AI untuk belajar dari pola dalam data besar. Sementara inference menggunakan AI untuk membuat keputusan berdasarkan informasi baru—inilah cara AI muncul dalam aplikasi sehari-hari.

Baik saat Anda memesan kopi lewat aplikasi Starbucks, berinteraksi dengan Salesforce untuk pekerjaan, atau berbicara lewat earbud—semuanya dilakukan melalui inference. Nvidia menjual GPU-nya langsung ke perusahaan AI seperti OpenAI (setidaknya 4 juta unit dalam kesepakatan terbaru) dan ke pemerintah asing termasuk Korea Selatan, Arab Saudi, dan Inggris.

Mereka juga menjual GPU ke penyedia cloud seperti Amazon, Microsoft, dan Google yang kemudian menyewakannya per jam, menit, atau detik. Nvidia bahkan punya program sewa GPU sendiri. Permintaan terhadap sistem yang mampu menangani beban kerja AI sangat tinggi—satu rak server 72 Blackwell dijual sekitar $3 juta, dan Nvidia mengabarkan mengirim seribu unit setiap minggu.

Bagi Nvidia, strategi utamanya adalah menjual seluruh sistem, bukan hanya chip. Di level sistem, efisiensi dalam hal kecepatan, daya, dan performa bisa dimaksimalkan. Tentu saja, Nvidia bukan satu-satunya pemain. Kompetitor utamanya, Advanced Micro Devices (AMD), mencatat kemajuan besar lewat lini GPU Instinct dengan komitmen besar dari OpenAI dan Oracle.

Perbedaan mencolok AMD terletak pada ekosistem software open-source yang mereka gunakan, sementara GPU Nvidia dioptimalkan ketat di sekitar CUDA—platform software proprietary milik Nvidia. GPU generasi berikutnya dari Nvidia, Ruben, dikabarkan akan masuk produksi penuh tahun depan.

Di masa awal booming model bahasa besar, training yang memakan banyak komputasi menjadi kunci—pekerjaan sempurna untuk GPU. Namun seiring model semakin matang, kebutuhan inference meningkat drastis. Teknik post-training kini membuat model sangat capable, dan untuk mengekstrak nilainya, inference menjadi prioritas. Inilah cara orang benar-benar menggunakan AI.

Inference bisa berjalan di chip yang kurang powerful, yang diprogram untuk tugas lebih spesifik. Di sinilah ASIC kustom berperan. Jika GPU seperti pisau Swiss Army yang mampu melakukan berbagai jenis matematika paralel untuk beban kerja AI yang berbeda, ASIC seperti alat satu fungsi—sangat efisien dan cepat, tapi terpasang keras untuk melakukan matematika spesifik untuk satu jenis pekerjaan saja.

ASIC jauh lebih efisien dalam menjalankan beban kerja tertentu. Namun begitu dispesialisasikan, chip tidak bisa diubah setelah terukir di silicon. Ada trade-off dalam hal fleksibilitas. GPU Nvidia yang harganya bisa mencapai $40.000 dan sulit didapat memang jadi andalan startup, karena membuat ASIC kustom sendiri jauh lebih mahal.

Biaya minimum untuk membuat ASIC adalah puluhan juta dolar, bahkan sering ratusan juta. Tapi bagi penyedia cloud terbesar yang mampu membelinya, ASIC kustom sangat menguntungkan karena lebih hemat daya dan mengurangi ketergantungan pada Nvidia. Mereka ingin menurunkan biaya AI dan punya kontrol lebih atas beban kerja yang mereka bangun. Meski begitu, mereka tetap bekerja sangat erat dengan Nvidia dan AMD karena mereka juga butuh kapasitas.

Google adalah yang pertama membuat ASIC kustom untuk akselerasi AI, menciptakan istilah Tensor Processing Unit (TPU) saat chip pertamanya keluar pada 2015. TPU juga turut membantu penemuan transformer di Google tahun 2017—arsitektur yang menggerakkan hampir semua AI modern. Kami berkesempatan tur ke lab chip Google pada 2024. Di dalam sana sebenarnya ada empat chip yang terhubung ke mesin host berisi CPU, dan kabel-kabel berwarna itu menghubungkan semua chip Trillium agar bekerja sebagai satu superkomputer besar.

Satu dekade setelah TPU pertama, Google baru saja merilis Ironwood, generasi ketujuh mereka, lengkap dengan kesepakatan besar bersama Anthropic untuk melatih LLM Claude menggunakan hingga satu juta TPU. Beberapa kalangan bahkan menilai TPU secara teknis setara atau bahkan lebih unggul dari Nvidia. Namun secara tradisional, Google hanya menggunakannya untuk keperluan internal. Ada banyak spekulasi bahwa dalam jangka panjang, Google mungkin membuka akses TPU lebih luas.

Amazon Web Services adalah penyedia cloud berikutnya yang merancang chip AI sendiri setelah mengakuisisi startup chip Israel, Annapurna Labs, pada 2015. AWS mengumumkan Inferentia pada 2018 dan meluncurkan Trainium pada 2022, kini mendekati generasi ketiga. Trainium bisa dibayangkan sebagai kluster bengkel-bengkel kecil dengan banyak tensor engine fleksibel, sementara TPU Google seperti satu pabrik besar dengan jalur konveyor rigid yang dispesialisasikan untuk matematika matriks.

Perbedaan nama memang cukup menceritakan. Tapi seiring waktu, chip Trainium terbukti bisa melayani beban kerja inference maupun training dengan baik. Rata-rata, Trainium memberikan performa harga 30 hingga 40 persen lebih baik dibanding vendor hardware lain di AWS.

Pada Oktober lalu, kami mengunjungi Indiana Utara untuk tur on-camera pertama di pusat data AI terbesar Amazon, tempat Anthropic melatih modelnya menggunakan setengah juta chip Trainium 2. Di belakang kami saat itu, mereka sedang merakit menara-menara yang nantinya menjadi Ultra Server. Yang menarik, tidak ada GPU Nvidia di sana sama sekali—meski AWS tetap mengisi pusat data lainnya dengan banyak GPU Nvidia untuk melayani pelanggan AI lapar seperti OpenAI.

Investasi yang mereka lakukan pada platform kami tetap signifikan, bahkan lebih besar dari yang terlihat di beberapa deployment ASIC mendatang. Ketika membicarakan ASIC kustom, Broadcom dan kompetitor utamanya Marvell tidak bisa dilewatkan. Keduanya bertindak sebagai mitra back-end sehingga klien tidak perlu merekrut tim silicon penuh untuk menangani semuanya sendiri.

Semua hyperscaler besar yang punya program ASIC bermitra dengan setidaknya satu perusahaan desain chip—Broadcom menjadi yang paling penting, menyediakan IP, knowhow, dan networking. Broadcom adalah salah satu penerima manfaat terbesar dari booming AI. Mereka membantu membangun TPU Google, Meta's Training and Inference Accelerator yang diluncurkan 2023, dan kini kesepakatan besar baru untuk membantu OpenAI membuat ASIC kustom sendiri mulai 2026.

Broadcom diperkirakan memenangkan 70 bahkan 80 persen pasar ini, dengan akselerasi pertumbuhan CAGR dua digit tengah selama lima tahun ke depan. Microsoft juga masuk ke arena ASIC, berharap bisa menggunakan chip Maia miliknya sendiri di pusat data Azure. Meskipun sedikit yang terungkap sejak rencana diumumkan pada 2023, dan chip Maia berikutnya mengalami penundaan.

Intel punya lini Gaudi sendiri berupa ASIC kustom untuk AI. Tesla mengumumkan ASIC mereka, dan Qualcomm mulai masuk ke chip pusat data dengan AI 200. Tentu saja, ada pula banyak startup yang all-in pada chip AI kustom—seperti Cerebras yang membuat chip AI wafer penuh berukuran besar, dan Groq dengan language processing unit yang fokus pada inference.

Kategori besar terakhir dari chip AI adalah yang dibuat untuk menjalankan edge AI di perangkat, bukan di cloud. Anda mungkin ingin menjalankan model AI secara lokal di perangkat pribadi, bahkan smartphone. Jadi ada modul di dalam prosesor chip tersebut yang memiliki kemampuan pemrosesan AI, sehingga Anda tidak perlu berkomunikasi kembali ke pusat data dan bisa menjaga privasi data di ponsel Anda.

NPU (Neural Processing Unit) adalah chip edge AI utama—akselerator AI khusus yang terintegrasi ke dalam chip utama ponsel atau laptop, yang disebut SoC (System on a Chip). SoC adalah chip yang memiliki banyak modul berbeda untuk melakukan aspek komputasi yang berbeda, karena jelas dalam ponsel Anda perlu sistem sangat padat yang mampu melakukan banyak hal. Jadi bukan chip AI yang dikemas terpisah. NPU mengambil lebih sedikit silicon dan karenanya biayanya lebih murah, sering kali jauh lebih murah dari chip pusat data besar.

NPU yang memungkinkan AI di PC terutama dibuat oleh Qualcomm, Intel, dan AMD. Untuk MacBook, chip M series buatan Apple sendiri juga menyertakan neural engine khusus, meski Apple tidak menggunakan istilah NPU. Akselerator neural serupa—prosesor kecil khusus untuk matematika AI—kini juga dibangun ke dalam chip A series iPhone terbaru, yang kami lihat pada September lalu.

Mengapa AI on-device begitu penting? Ketika kita bisa melakukan sesuatu di perangkat, kita mampu mengelola privasi orang dengan cara terbaik. Hal lain, ini efisien bagi kita dan responsif. Kita jauh lebih punya kontrol atas pengalaman tersebut. Ponsel Android terbaru juga memiliki NPU untuk AI yang dibangun ke dalam chip Snapdragon Qualcomm utama mereka. Samsung punya NPU sendiri di ponsel Galaxy juga.

NPU juga menggerakkan AI di mobil, robot, kamera, perangkat smart home, dan lainnya yang dibuat oleh perusahaan seperti NXP dan Nvidia. Saat ini, sebagian besar perhatian dan dolar memang mengarah ke pusat data, tapi seiring waktu itu akan berubah karena AI akan digunakan di ponsel, mobil, wearable, dan berbagai aplikasi lain dalam skala jauh lebih besar dari sekarang.

Lalu ada FPGA (Field Programmable Gate Array) yang bisa digunakan di pusat data atau tertanam di perangkat. Chip ini bisa dikonfigurasi ulang dengan software setelah dibuat untuk digunakan di berbagai aplikasi seperti pemrosesan sinyal, networking, dan ya, AI. Meski jauh lebih fleksibel dari NPU atau ASIC, FPGA memiliki performa mentah dan efisiensi energi yang lebih rendah untuk beban kerja AI.

Anda akan memilih FPGA karena tidak ingin harus mendesain ASIC sendiri. Tapi jika Anda akan mengoperasikan ribuan unit, ASIC lebih murah. AMD menjadi pembuat FPGA terbesar setelah mengakuisisi Xilinx seharga $49 miliar pada 2022, dengan Intel di posisi kedua berkat pembelian Altera senilai $16,7 miliar pada 2015.

Setelah membedah semua jenis chip AI dan pemain terbesar yang merancangnya, penting untuk membahas di mana chip-chip ini sebenarnya diproduksi. Karena raksasa seperti Nvidia, Google, dan Amazon hampir semuanya bergantung pada satu perusahaan untuk membuat semuanya: Taiwan Semiconductor Manufacturing Company (TSMC).

Sebagian besar diproduksi di Taiwan, dan itu menjadi isu geopolitik baru dalam industri semikonduktor. Maju cepat melalui CHIPS Act hingga hari ini, TSMC kini memiliki pabrik fabrikasi chip raksasa baru di Arizona tempat kami mendapat tur on-camera pertama pada Desember lalu. Apple telah berkomitmen memindahkan sebagian produksi chip ke TSMC Arizona, meski chip A19 Pro iPhone terbarunya dibuat dengan teknologi 3 nanometer TSMC yang saat ini hanya mungkin di Taiwan.

Blackwell milik Nvidia dibuat dengan node 4 nanometer TSMC, yang artinya kini mereka memproduksi Blackwell secara penuh di Arizona. Dengan bantuan investasi besar dari pemerintah AS, Intel menghidupkan kembali bisnis foundry-nya dan juga membuat chip node 18A canggih di fab Arizona yang baru. Bisa dibilang AI membawa Silicon kembali ke Silicon Valley—itu analisis yang bagus. Ini menciptakan peluang luar biasa tidak hanya untuk manufaktur chip di sini, tapi juga memanfaatkan physical AI dan berbagai kemampuan lain yang membantu memajukan banyak manufaktur yang akan kembali ke sini, memastikan AS tetap kompetitif secara global.

Huawei, ByteDance, dan Alibaba adalah beberapa pemain besar China yang membuat ASIC kustom, meski mereka dibatasi oleh kontrol ekspor pada peralatan paling canggih dan chip AI seperti Blackwell milik Nvidia. Pembeda besar lainnya adalah siapa yang bisa mengamankan cukup daya untuk seluruh pembangunan pusat data AI yang masif ini.

Jika AS ingin terus memimpin dalam AI, kita terus dihadapkan dengan risiko energi. China melakukannya jauh lebih baik dari kita. Dan meski kita memiliki chip terbaik di dunia—saya percaya beberapa generasi lebih maju—kebutuhan kita untuk membangun energi sangat kritis.

Namun dengan posisi Nvidia sebagai perusahaan paling berharga di dunia, perusahaan-perusahaan tidak melambat dalam perlombaan membuat chip AI mereka sendiri. Meski menggulingkan Nvidia tidak akan mudah. Mereka punya posisi itu karena mereka mendapatkannya, mereka menghabiskan bertahun-tahun membangunnya, dan mereka memenangkan ekosistem developer tersebut. Tapi pasar ini akan menjadi sangat besar sehingga kita akan terus melihat pendatang baru.